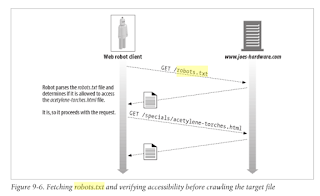

Os motores de busca coletam informações sobre o conteúdo da Web automaticamente. Eles usam softwares especiais que sistematicamente "rastreiam" a Web, seguindo os links que encontra em páginas da Web. Estes softwares geralmente são chamados de rastreadores da Web, ou uma aranha, ou mesmo um robô. Os sites individuais podem controlar o modo como os mecanismos de pesquisa controlam o site instalando um arquivo especial chamado "ROBOTS.TXT". Se o arquivo estiver presente, um rastreador examina seu conteúdo para obter instruções antes de rastrear o site.

Subscribe to:

Post Comments (Atom)

Explain the unique risks and threats posed by AI-enabled attacks.

AI-enabled attacks present unique risks primarily due to the speed and scale at which they occur, making standard countermeasures difficult...

-

Summarization of hundreds of comments on Reddit. Ineffective Service: The users explicitly states, "Confirmed that it doesn't w...

-

Based on a review of the provided Privacy Policy , here are some potential legal implications and issues that should be addressed: Scope a...

No comments:

Post a Comment